|

Computação

Quântica

Ivan

S. Oliveira

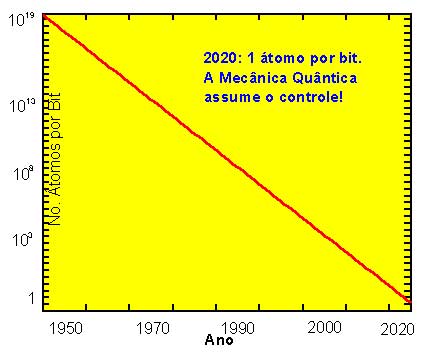

O tamanho dos componentes eletrônicos que representam bits

em chips de computadores vem sendo reduzido de maneira vertiginosa

desde os anos 50, e espera-se que até 2020 esse tamanho alcance

dimensões atômicas. Ou seja, se alcançará

o limite onde 1 bit de informação será representado

por apenas 1 átomo. Durante as décadas de 80 e 90

os físicos descobriram novas e fascinantes propriedades computacionais

que só podem existir nesse limite, graças às

Leis da Mecânica Quântica, a teoria física que

governa o comportamento de átomos e moléculas.

1.

Mundo Clássico vs. Mundo Moderno

Até o início do século XX os físicos

explicavam os fenômenos naturais utilizando como arcabouço

duas teorias de alcance extraordinário: a Mecânica

de Newton e o Eletromagnetismo de Maxwell. A primeira estuda o movimento

dos corpos, como a órbita de um cometa ou a trajetória

de um pêndulo, enquanto que a segunda trata de fenômenos

eletromagnéticos, tais como a luz ou ondas de rádio.

A Mecânica e o Eletromagnetismo formam os principais pilares

do que é conhecido como Física Clássica. Havia

naquela época uma crença de que essas duas teorias

seriam capazes de explicar todos os fenômenos observados na

natureza, restando apenas aos físicos aplicá-las corretamente

cada vez que um novo fenômeno fosse descoberto. Era o império

da Física Clássica.

No

entanto, duas grandes reviravoltas nessa maneira de pensar acabaram

por demolir a soberania da Física Clássica: a Teoria

da Relatividade e a Mecânica Quântica. A Relatividade,

formulada por Albert Einstein, é a parte da Física

que trata de fenômenos envolvendo objetos que se movem com

velocidades muito altas, próximas à velocidade da

luz (300 000 km/s), ou aqueles fenômenos envolvendo objetos

com massas astronômicas, como aglomerados, galáxias,

etc. A Mecânica Quântica, por sua vez, descreve o comportamento

de objetos com dimensões atômicas (0,0000000001 m)

e menores. A Mecânica Quântica se desenvolveu e se tornou

a mais bem sucedida teoria física, no que diz respeito às

previsões que faz para o comportamento da matéria.

Como alguns exemplos de grandes sucessos de aplicações

da Mecânica Quântica, podemos citar a descrição

do comportamento para os semicondutores, que são a base da

tecnologia dos chips dos computadores atuais, e também para

os supercondutores, materiais que conduzem corrente elétrica

sem dissipação de energia, e ainda a compreensão

da estrutura do núcleo atômico que possibilitou o uso

da energia nuclear em diversas aplicações.

2.

Computação Clássica

Paralelamente ao desenvolvimento da Mecânica Quântica,

uma outra revolução tomou corpo na década de

30, através principalmente do trabalho do matemático

e lógico inglês Alan Turing. Atendendo a um desafio

de um outro grande matemático da época, David Hilbert,

Turing criou um modelo computacional abstrato que se tornou um paradigma

de computação conhecido como Máquina de Turing.

Em última análise, uma máquina de Turing é

um aparato idealizado que opera com seqüências lógicas

de unidades de informação chamadas de bits

(do inglês binary digit). Um bit pode adquirir apenas

um dentre dois valores: "0" ou "1". Qualquer

informação é codificada e processada como uma

seqüência de 'zeros' e 'uns' em uma máquina de

Turing. Um computador, tal qual os que temos hoje sobre as nossas

mesas, é uma realização física de uma

máquina de Turing. Toda informação fornecida

a eles é lida, processada e retornada sob a forma de seqüências

de bits.

Por

serem idealizações matemáticas, máquinas

de Turing independem de quais objetos físicos irão

representar bits, bastando apenas que eles existam. Nos computadores

atuais, esses objetos são componentes eletrônicos que

existem aos bilhões dentro dos chips. A necessidade do aumento

de memória e da velocidade de processamento fizeram com que

os chips cada vez mais acomodassem um número maior desses

componentes. Em 1970, Gordon Moore, um dos fundadores da empresa

fabricante de microprocessadores Intel, percebeu que havia um crescimento

muito rápido no número de componentes por unidade

de volume nos chips ao longo dos anos e, consequentemente, uma redução

no "tamanho físico" dos bits. Traduzindo em números

de átomos necessários para representar um bit de informação,

podemos ter uma idéia dessa redução: em 1950

eram necessários cerca de 10^19 (10 elevado a

19) átomos para representar um bit. Atualmente são

"apenas" cerca de 10^9 (10 elevado a 9), uma

redução de 10 ordens de magnitude! Se aplicarmos a

Lei de Moore e fizermos uma projeção sobre os próximos

vinte anos, o resultado é algo espantoso: em 2020, um bit

de informação será representado por apenas

1 único átomo!

Aparentemente,

isto poderia significar o limite físico natural dos computadores.

Com 1 átomo representando 1 bit, não haveria mais

como aumentar a densidade de bits por chip e consequentemente não

seria mais possível aumentar a capacidade dos computadores.

No entanto, não é assim. De fato, algo muito mais

dramático do que uma mera limitação física

de memória deverá acontecer até 2020 e a razão

é bem simples: na escala atômica, o paradigma clássico

da Máquina de Turing deixa de ser válido, pois quem

governa os fenômenos físicos nessa escala é

a Mecânica Quântica, e os processos computacionais deverão

obedecer às leis dessa teoria física, e não

às regras de uma idealização matemática.

3.

Computação Quântica

Na escola aprendemos a calcular a posição, velocidade,

energia, etc. de objetos que se movem, aplicando as leis da Mecânica

de Newton. No mundo dos átomos e moléculas estas leis

não funcionam. Para descrever corretamente o comportamento

desses objetos, é preciso utilizar as leis da Mecânica

Quântica. Essa diferença tem conseqüências

dramáticas para a computação, e a razão

é a seguinte: os circuitos eletrônicos que representam

os bits de informação nos computadores atuais são

objetos clássicos, e portanto seguem as leis da física

clássica. Como conseqüência, cada bit em um computador

clássico só pode adquirir um dos valores, "0"

ou "1", que são, por sua vez, mutuamente excludentes.

Acontece que no mundo dos átomos, a Mecânica Quântica

nos ensina que os bits (que no caso quântico são chamados

de quantum-bits, ou qubits ) podem simultaneamente

adquirir os valores "0" e "1"! Esta propriedade

é chamada de superposição de estados quânticos,

e para entender o seu alcance, considere a seguinte analogia: suponha

que você tenha uma moeda e esteja brincando de "cara

ou coroa". Você joga a moeda para o alto e sabe que ao

cair no chão, o resultado será ou "cara"

ou "coroa", com probabilidade igual a 50% para cada lado.

Se a moeda fosse um objeto quântico, o resultado poderia ser

"cara", "coroa", ou qualquer superposição

dos dois, como se a moeda pudesse cair com as duas faces para cima

ao mesmo tempo! Se você atribuir o estado lógico "0"

para "cara" e "1" para "coroa", você

poderia, com uma moeda quântica, superpor os estados lógicos

que classicamente são excludentes.

Essa

estranha propriedade da superposição já foi

demonstrada muitas vezes em laboratórios de física

em todas as partes do mundo, e é uma verdade incontestável.

Para a computação, ela representa um ganho inimaginável

de velocidade de processamento, pois todas as seqüências

de bits possíveis em um computador poderiam ser manipuladas

simultaneamente. A demonstração mais espetacular deste

ganho de velocidade foi feita em 1993 por um cientista americano

chamado Peter Shor. Ele inventou um algoritmo quântico para

fatorar números grandes, um problema muito difícil

para computadores clássicos. A tabela abaixo mostra comparações

entre os tempos de fatoração necessários para

algoritmos clássicos e o algoritmo de Shor, em função

do tamanho do número a ser fatorado.

| Comprimento

do número a ser fatorado (em bits) |

Tempo

de fatoração por algoritmo clássico |

Tempo

de fatoração com o algoritmo de Shor |

| 512 |

4

dias |

34

segundos |

| 1024 |

100

mil anos |

4,5

minutos |

| 2048 |

100

mil bilhões de anos |

36

minutos |

| 4096 |

100

bilhões de quatrilhões de anos |

4,8

horas |

A dificuldade

na fatoração de números grandes é a

base da segurança de mensagens criptografadas que viajam

todos os dias pela Internet levando informações secretas

(como números de cartões de créditos). O algoritmo

de Shor mostra que no dia em que um computador quântico for

ligado, nenhuma mensagem criptografada classicamente será

secreta.

Os

próximos 20 anos serão muito interessantes para a

computação.

Ivan S. Oliveira é pesquisador do Centro Brasileiro de

Pesquisas Físicas.

|