Jean-Jacques de Groote

A quântica é uma teoria fundamental para os avanços tecnológicos de nosso mundo atual e do vasto conhecimento científico que estamos adquirindo. Grandes avanços práticos e teóricos em áreas como astronomia, medicina, biologia, química e física são frutos de sua aplicação. Seus conceitos causaram um revolução na forma como entendemos o universo, mostrando que o comportamento da matéria a nível atômico não obedece a regras bem estabelecidas de nosso mundo macroscópico.

Apesar de entrar em conflito inclusive com nosso conceito de realidade, a teoria quântica se mostrou correta e permitiu em aplicações práticas a revolução tecnológica que nos trouxe computadores, celulares, laseres, ressonância magnética, genética molecular, entre outros. Em termos de teoria temos uma maior compreensão do universo, desde o big-bang até o comportamento das moléculas, átomos e seus constituintes.

Os primeiros passos para seu desenvolvimento foram dados no início do século XX. Até então a física era baseada nas teorias clássicas de Newton para as partículas e a de Maxwell, que unificou as teorias elétrica magnética gerando o eletromagnetismo. Essas teorias descrevem com precisão os fenômenos que vemos em nosso mundo macroscópico, como o movimento dos corpos celestes e a natureza eletromagnética da luz. No entanto, o avanço das técnicas experimentais no fim do século XIX permitiu que os cientistas passassem a estudar a natureza com maior detalhe, abrindo caminho para uma análise do comportamento dos sistemas muito pequenos, como átomos e moléculas. O resultado da tentativa de explicar os resultados experimentais foi uma nova teoria que revolucionou nossa forma de compreender a natureza do universo. Foi necessário abandonar conceitos básicos como a noção de trajetória de uma partícula quando verificou-se que não seria possível determinar simultaneamente a posição e a velocidade, de um elétron por exemplo.

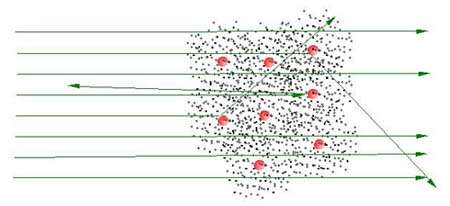

Um dos experimentos que levou a uma maior compreensão de como a matéria é formada foi a determinação da estrutura dos átomos na forma de núcleos de carga positiva cercados por elétrons. Os elétrons haviam sido descobertos em 1897 por Joseph John Thomson mas, já que não havia razão para supor que as cargas positivas estariam aglutinadas em um núcleo, Thomson propôs um modelo atômico onde os elétron estaria imersos em cargas positivas (como passas em um pudim). Por algum tempo este modelo prevaleceu, até que em 1911, estudando como partículas eram espalhadas por folhas de metal Rutherford concluiu que o átomo seria formado por um núcleo de carga positiva cercado por elétrons.

|

|

Experimento

de Rutherford - Partículas radioativas incidem sobre uma folha

de ouro. A maioria destas partículas passa através da folha pois

são muito mais pesadas que os elétrons (pontos pretos). Rutherford

verificou que as cargas positivas são localizadas em pequenos núcleos

(esferas vermelhas). Desta forma explicaria porque as partículas

incidentes são as vezes desviadas de sua trajetória. Antes deste

experimento acreditava-se que as cargas positivas não eram localizadas

em núcleos.

|

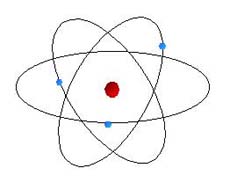

Assim, o modelo Atômico de Rutherford se assemelhava a uma versão microscópica do modelo planetário, mas ao invés da força gravitacional, a força elétrica é a principal responsável pela atração elétron-núcleo. Este é o modelo atômico mais comumente encontrado na literatura moderna, embora verificou-se ser incompleto.

|

|

Modelo

Planetário do Átomo - O elétron orbitaria o núcleo de forma

semelhante a um planeta em torno do sol, mas numa escala muito menor

devido a força principal de atração do núcleo ser elétrica, que

é muito mais forte que a gravitacional.

|

No entanto, havia um problema. Verifica-se que quando cargas são aceleradas, acabam perdendo energia por emissão de radiação eletromagnética. Como um elétron em órbita de um núcleo está sempre sob aceleração, deve emitir energia também, diminuindo assim o raio de sua órbita. Fazendo os cálculos desta perda de energia os cientistas verificaram que os elétrons colapsariam no núcleo em um intervalo de tempo extremamente pequeno. Se isso acontecesse, o universo teria deixado de existir logo após sua criação.

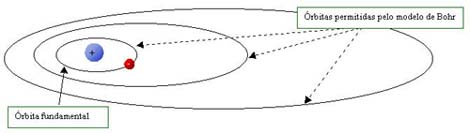

Para complicar ainda mais o modelo planetário outro fenômeno incomum aparece quando estuda-se a luz emitida ou absorvida pelo átomo. Os resultados sugeriam que o elétron não poderia estar em qualquer órbita em torno do núcleo. Foi o que propôs o físico dinamarquês Niels Bohr em 1913. Mais do que isso, foi necessário assumir que existiria uma órbita de raio mínimo, ou seja, uma órbita fundamental da qual o elétron só pode mudar para uma órbita mais alta, evitando assim que colapse no núcleo.

Como para cada órbita existe uma energia associada, Bohr verificou que as energias da luz emitida nas mudanças de órbitas seriam discretas (não contínuas). Ou seja, as energias da luz emitida seriam "quantizadas". Este modelo está inspirado na proposta feita em 1900 por Max Planck, que sugeriu que partículas oscilando em um sistema chamado corpo negro emitiriam quantidades discretas de energia, fato sem explicação pelas teorias clássicas.

|

|

Modelo

Atômico de Bohr - No caso do átomo mais simples, o do hidrogênio,

com apenas um elétron ligado ao núcleo, o modelo de Bohr previa

que o raio da próxima órbita após a órbita fundamental teria um

raio quatro vezes maior. A terceira órbita com raio nove vezes maior,

e assim em diante. Para este átomo o elétron só pode mudar de uma

órbita para outra. Assim, se um partícula atingisse o elétron a

órbita não seria alterada, a menos que a partícula transferisse

ao elétron energia suficiente para passar à próxima órbita ou outra

órbita permitida. Se a teoria clássica fosse válida, qualquer órbita

seria permitida.

|

Apesar de não explicar o motivo deste modelo ser desta forma, e de falhar quando átomos com mais elétrons são considerados, Bohr incentivou outros pesquisadores para estudá-lo, prevendo que a quantização seria o caminho para explicar o comportamento da matéria.

Um passo importante para a explicação dos sucessos da teoria de Bohr, e que abriria as portas para a uma teoria consistente, foi dado pelo físico francês Louis De Broglie. Em sua tese de doutoramento, em 1924, De Broglie fez uma proposição de simetria baseada em uma teoria de Einstein de 1905 de que a luz pode, em algumas condições, se comportar como partícula. Não poderiam as partículas apresentar um comportamento de ondas? Aplicando esta suposição ao modelo de Bohr ele supôs que o elétron teria uma onda associada ao longo de sua órbita em torno do próton. Mas apenas algumas órbitas seriam possíveis para que a onda não interferisse destrutivamente consigo mesma. Essas órbitas especiais eram exatamente as propostas por Bohr! Este resultado abriu caminho para uma nova interpretação do elétron e da matéria em geral. As partículas teriam um novo comportamento chamado de partícula-onda. Se o elétron colidir com um detetor, um ponto bem definido será registrado, como espera-se de uma partícula. Mas o elétron mostra claramente, em alguns experimentos, que tem um comportamento ondular associado a ele.

Inicialmente o trabalho de De Broglie teve pouca atenção pela comunidade científica até ser lido por Einstein, que ficou entusiamado com a proposta. O físico Austríaco Erwin Schrödinger examinou esta teoria e descartou o trabalho, mas, após um novo exame, acabou percebendo sua importância. Mais do que isso, dedicou-se a desenvolvê-lo e o resultado foi uma das mais importantes contribuições a nossa compreensão do que é a matéria. Indo além de De Broglie, em 1926 Schrödinger definiu uma equação que descrevia o comportamento ondular completo de uma partícula, em três dimensões. O resultado não apenas reproduziu os resultados de Bohr para as energia do átomo hidrogênio, como explica com grande precisão as propriedades dos átomos em geral, e, consequentemente, abriu as portas para uma descrição matemática de sólidos, líquidos, semicondutores, e assim em diante.

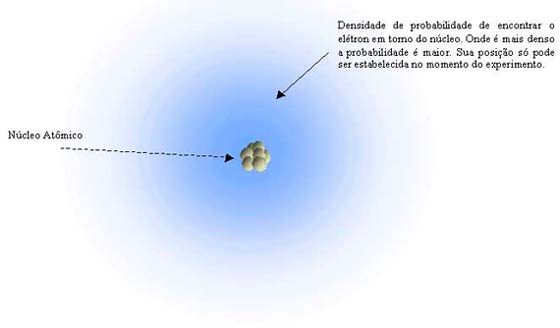

Na formulação de Schrödinger não é possível determinar a trajetória de uma partícula, o que levou a interpretações que vão totalmente além de nossa concepção macroscópica. Este resultado já havia sido apresentado no trabalho de outro fundador da Teoria Quântica, Werner Heisenberg. Usando uma formulação diferente, mas equivalente a de Schrödinger, determinou o chamado princípio da incerteza. Segundo este, quando maior a precisão na determinação experimental da posição de um elétron, menor a precisão na determinação de sua velocidade, e vice-versa. Como ambos são necessário para definir uma trajetória, este conceito teria que ser descartado. Muitos físicos passaram a assumir que o elétron não estaria necessariamente em lugar nenhum, até que fosse detectado em um experimento. As informações que podem ser obtidas passam a ser em qual região do espaço é mais provável encontrar o elétron. Esta probabilidade estaria relacionada com o modulo da função de onda associada ao elétron para uma dada energia. O resultado se mostrou correto, mas levou também a um conflito, pois passou-se de uma formulação determinista para uma estatística. Não se determina mais onde o elétron está, mas qual a probabilidade de que esteja em uma região do espaço.

|

|

Modelo

atômico de Schrödinger - A partir das equações de Schrödinger

não é possível determinar a trajetória do elétron em torno do núcleo,

mas, a uma dada energia do sistema, obtém-se a região mais provável

de encontrá-lo.

|

O modelo de Bohr, que era limitado ao átomo de hidrogênio, foi adaptado para procurar salvar o conceito de uma órbita definida, mas sem sucesso. Einsten foi um dos que se opôs à interpretação estatística, e a base de suas críticas são geralmente representadas pela frase "Deus não joga dados". Apesar de ter sido fundamental para a teoria quântica, dedicou-se a uma longa discussão teórica contra os físicos quânticos, especialmente sob a orientação de Bohr e seu grupo da chamada "Escola de Copenhague". As contraposições de Einstein, que buscava erros na teoria quântica, foram explicadas por Bohr e seu grupo, e ajudaram a firmar a mecânica quântica como uma formulação correta.

Ao longo dos anos a teoria Quântica foi sendo aperfeiçoada e novos fenômenos previstos ou explicados. Da união desta teoria com a teoria da relatividade de Einstein, Paul Dirac pôde predizer em 1931 a existência das anti-partículas, o que veio a ser confirmado experimentalmente. Toda uma nova família de partículas e de campos para suas interações vieram a ser descobertos. Ainda existem grandes desafios teóricos na explicação de fenômenos cada vez mais detalhados da matéria e suas interações, como o comportamento dos buracos negros, o big-bang, o interior dos prótons, neutrons, e das partículas que vem sendo descobertas. Mas para fenômenos atômicos a formulação de Schrödinger continua sendo a base dos trabalhos teóricos, da mesma forma que a teoria de Newton ainda é aplicada para o estudo das trajetórias de planetas e cometas, entre outros fenômenos macroscópicos. O futuro da quântica promete grandes avanços teóricos e experimentais, como por exemplo supercondutores eficientes a temperatura ambiente, teletransporte (de partículas simples), laseres de matéria utilizando um novo estado da matéria chamado de condensado de Bose-Einstein, computadores quânticos que podem processar enormes quantidades de informação, holografia do corpo humano, entre outros.

Jean-Jacques de Groote é pesquisador da Fapesp no Instituto de Química da Universidade Estadual Paulista (Unesp) em Araraquara, SP.

Atualizado em 10/05/2001

http://www.comciencia.br

contato@comciencia.br

© 2001

SBPC/Labjor

Brasil